https://www.scieneers.de/wp-content/uploads/2025/09/PyData-Berlin-Bild.png

1260

2240

shinchit.han@scieneers.de

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

shinchit.han@scieneers.de2025-09-05 17:43:282025-09-10 14:18:32PyData 2025

https://www.scieneers.de/wp-content/uploads/2025/09/PyData-Berlin-Bild.png

1260

2240

shinchit.han@scieneers.de

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

shinchit.han@scieneers.de2025-09-05 17:43:282025-09-10 14:18:32PyData 2025 https://www.scieneers.de/wp-content/uploads/2025/09/PyData-Berlin-Bild.png

1260

2240

shinchit.han@scieneers.de

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

shinchit.han@scieneers.de2025-09-05 17:43:282025-09-10 14:18:32PyData 2025

https://www.scieneers.de/wp-content/uploads/2025/09/PyData-Berlin-Bild.png

1260

2240

shinchit.han@scieneers.de

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

shinchit.han@scieneers.de2025-09-05 17:43:282025-09-10 14:18:32PyData 2025

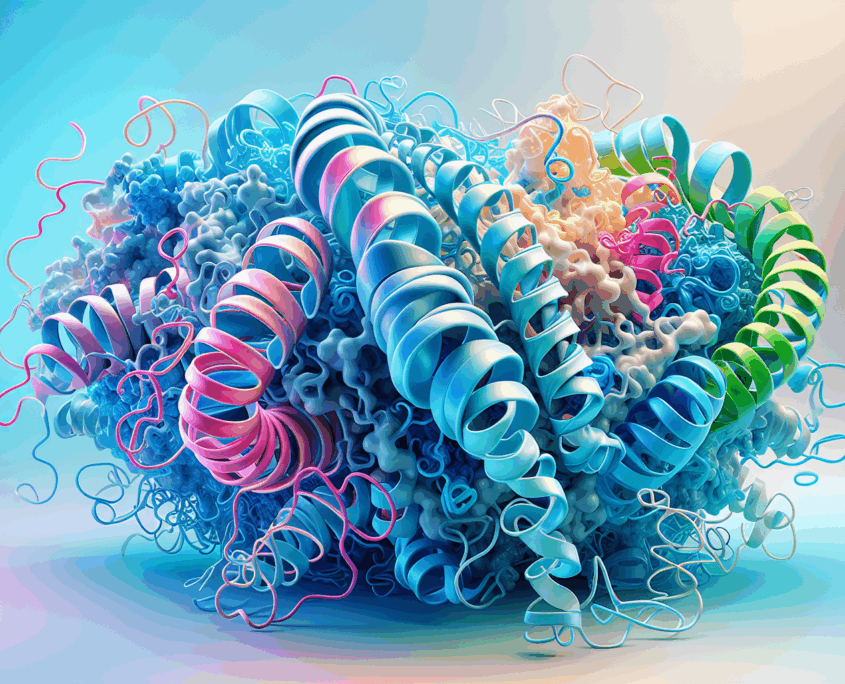

Machine Learning Workflow zur Bewertung genetischer Varianten auf Basis von Proteinstruktur Embeddings

Missense-Varianten, also einzelne Aminosäureaustausche im Protein, sind oft schwer zu bewerten. Unser Machine-Learning-Workflow nutzt proteinstrukturbasierte Graph-Embeddings, um die Pathogenität solcher Varianten vorherzusagen. Dabei verbessern die strukturellen Informationen bestehende Ansätze wie den CADD-Score und bieten neue Einblicke für die genommedizinische Diagnostik.

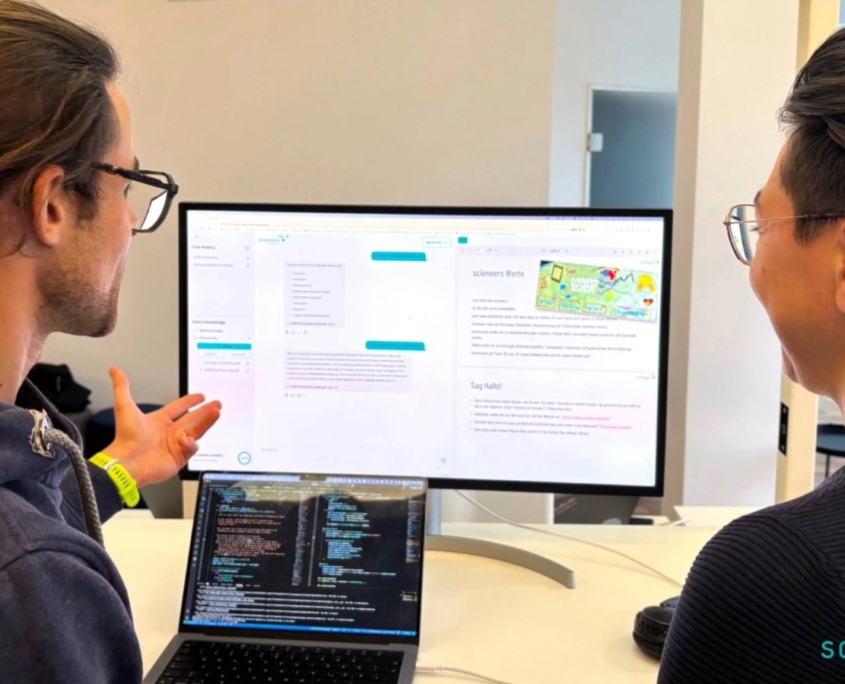

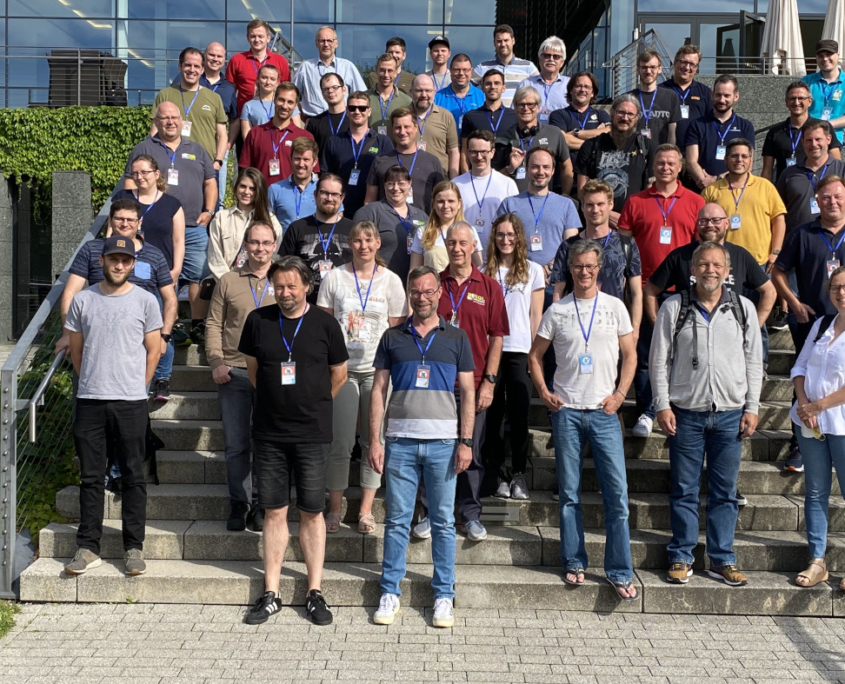

Rückblick auf unser Frühlingsevent 2025

Zwei Tage lang haben sich die meisten Kolleginnen und Kollegen aus Karlsruhe, Köln und Hamburg in Hamburg getroffen, um sich über fachliche und interne Themen auszutauschen, neue Impulse zu erhalten und gemeinsame Erlebnisse zu teilen.

Microsoft Fabric: Mit Eventstreams Echtzeitdaten verarbeiten

Wir geben einen Überblick zur Verarbeitung von Echtzeitdaten mit Eventstreams in Microsoft Fabric.

Real-Time Intelligence: Echtzeitdaten in Microsoft Fabric

Mit Real-Time Intelligence in Microsoft Fabric lassen sich Datenströme blitzschnell auswerten. Wir geben einen kompakten Überblick und erklären, was dahintersteckt.

M3 2025

Auf der diesjährigen Minds Mastering Machines (M3) Konferenz in Karlsruhe standen neben Best Practices zu GenAI, RAG-Systemen auch Praxisberichte aus verschiedenen Branchen, Agentensysteme und LLM sowie rechtliche Aspekte von ML im Fokus. Wir haben drei Vorträge zu unseren Projekten gehalten.

Wärmebedarf prognostizieren mit Temporal Fusion Transformern

Globale Modelle wie TFT und TimesFM revolutionieren die Fernwärmeprognose, indem sie präzisere Vorhersagen ermöglichen, Synergien zwischen Systemen nutzen und das Cold-Start-Problem effektiv lösen.

Kleinere Docker Images mit uv

Die Größe von Docker-Images durch intelligentes Abhängigkeitsmanagement und Optimierungstechniken reduzieren, wie z. B. die Verwendung von deptry", um unbenutzte Bibliotheken zu bereinigen, die Verwendung alternativer Indizes für reine CPU-Pakete und die Erstellung effizienter Docker-Dateien mit uv"-Beispielen. Außerdem gibt es einen Tipp für Azure WebApp-Deployments.

Microsoft Fabric Webinar 2025

In unseren Webinaren: Microsoft Fabric Einführung und Microsoft Fabric - Echtzeit-Dashboards mit KQL-Terminen lernen Sie Fabric kennen.

Mit Scrum erfolgreich sein in Forschung und Entwicklung

Erfolg in Forschung und Entwicklung (F&E) mit Scrum hängt von effektiver Wissensgewinnung und -verwertung ab. Spikes als Methode zur Risikominimierung in Scrum spielen dabei eine zentrale Rolle. Der Artikel diskutiert, wie Spikes effizient eingesetzt, priorisiert und dokumentiert werden können, und präsentiert bewährte Praktiken aus einem R&D-Projekt, darunter regelmäßige Spike-Pflegetermine und ein Laborbuch für Erkenntnisse, ergänzt durch angepasste Definitionen von Ready und Done.

Microsoft Fabric Deployment

Microsoft Fabric ist eine dynamische Plattform für Datenanalyse und -entwicklung, die sowohl für Power-BI-Nutzer als auch für IT-Experten maßgeschneiderte Lösungen bietet. Dieser Blogpost diskutiert Entwicklungsmöglichkeiten, Kollaborationswerkzeuge und Deployment-Szenarien, inklusive der Nutzung von Fabric's GUI, lokalen Client-Tools und Git-Integrationen. Es werden außerdem verschiedene Deployment-Strategien erläutert, die von einfachen Fabric Deployment Pipelines bis hin zu komplexeren branch-basierten Deployments reichen, um den Anforderungen verschiedenster Workloads gerecht zu werden.

DesinfoNavigator

DesinfoNavigator ist ein Online-Tool, das Nutzer beim Erkennen von Desinformation unterstützt, indem es Texte auf irreführende rhetorische Strategien untersucht. Es basiert auf dem PLURV-Framework und verwendet ein großes Sprachmodell, um Indizien für Desinformation zu identifizieren und Handlungsanweisungen zur Überprüfung zu generieren. Es ergänzt Faktenchecks, ist kostenlos und fördert kritisches Denken im Umgang mit Informationen.

Benefits bei scieneers

Scieneers bietet ein attraktives Arbeitsumfeld mit flexiblen Arbeitszeiten, Home-Office, Kita-Zuschuss, Mitarbeiter-Events, Weiterbildungsbudgets, Mitarbeiterbeteiligung, betrieblicher Altersvorsorge und moderner Technik. Inklusion, Transparenz und Nachhaltigkeit prägen die Firmenkultur, die Diversität und Teamgeist fördert.

KI trifft Datenschutz: Unsere ChatGPT-Lösung für Unternehmenswissen

Unsere ChatGPT-Lösung ermöglicht es Unternehmen, firmeninternes Wissen sicher und datenschutzkonform zu nutzen. Mittels eines modularen Systems, das auf unternehmensspezifische Datenquellen wie SharePoint und OneDrive zugreift, können Mitarbeiter schnell und einfach auf Informationen zugreifen. Die Lösung bietet personalisierte Budgetverwaltung, sichere Authentifizierung und eine anpassbare Benutzeroberfläche, inklusive Feedback-Mechanismen für kontinuierliche Verbesserungen.

Wie Studierende von LLMs und Chatbots profitieren können

In der Hochschulbildung revolutionieren Large Language Models (LLMs) und Retrieval Augmented Generation (RAG) das Lernen. Ein Projekt der Universität Leipzig zeigt den Erfolg von KI-Tutoren im Jura-Studium, die personalisierte Antworten bieten und auf Ressourcen verweisen. Vorteile für Studierende und Lehrende sind maßgeschneiderte Unterstützung und effiziente Lehrmaterialentwicklung, trotz Herausforderungen wie Ressourcenbedarf und Antwortqualität. Azure und OpenAI unterstützen mit sicherer Infrastruktur.

KI für das Gemeinwohl auf dem Digital-Gipfel 2024

Wir durften unser durch den Civic Coding-Accelerator gefördertes LLM-Projekt StaatKlar an Tag 2 des Digital-Gipfels 2024 vorstellen. Für alle Neugierigen hier eine kurze Zusammenfassung unseres Projekts und des Gipfels.

Der Einsatz von VideoRAG für den Wissenstransfer im Unternehmen

VideoRAG bietet einen innovativen Ansatz zur Überbrückung von Wissenslücken in Unternehmen, indem Video- und Textdaten mit Hilfe von generativer KI und Retrieval-Augmentation in eine durchsuchbare Wissensdatenbank umgewandelt werden. Es gewährleistet einen effizienten Transfer von nuanciertem Wissen, einschließlich des impliziten Wissens erfahrener Mitarbeiter, über KI-basierte Chatbots und macht es so auch jüngeren Generationen innerhalb der Belegschaft zugänglich.

Data Factory in Fabric – the good, the bad and the ugly

Data Factory in Fabric – das Gute, das Schlechte und das Hässliche: Vorträge auf SQL Konferenzen zeigen Entwicklungen der Microsoft Fabric Data Factory auf. Vorteile wie erweiterte Features und einfache Migration werden ebenso besprochen wie Herausforderungen, darunter mangelnde Effizienz bei kleinen Projekten und technische Mängel. Microsoft arbeitet an Verbesserungen dieser vielversprechenden Technologie.

Multi-Agenten LLM auf der Data2Day

Auf der Data2Day Konferenz durften wir dieses Jahr zusammen mit Bertelsmann unser Multi-Agenten-LLM Projekt vorstellen. Für alle die nicht dabei waren, hier eine kleine Zusammenfassung unseres Vortrags und der sonstigen Konferenz-Highlights.

Logic App API Connections – Herausforderungen und Lösungswege in der Verwaltung

API-Connections sind entscheidend für Azure Logic Apps, um externe Dienste zu integrieren. Die Erstellung kann Verwaltungsherausforderungen mit unklaren Ressourcennamen mit sich bringen. Lösungswege umfassen manuelles Umbenennen über ARM-Templates und Automatisierung mit PowerShell, um die Verwaltung effizienter zu gestalten und die Einbindung in CI/CD-Prozesse zu erleichtern.

Diversity als Chance ➯ scieneers & Charta der Vielfalt

Wir, bei scieneers GmbH, verstehen die Rolle, die Diversity in der Arbeitswelt spielt und haben entsprechend die Charta der Vielfalt unterzeichnet.

European Society of Human Genetics

European Society of Human GeneticsEinblicke in die European Society of Human Genetics Konferenz 2024

Einblicke in die European Society of Human Genetics (ESHG) 2024 - eine beeindruckende, hybriden Veranstaltung, die Tausende von Besuchern aus aller Welt anlockte.

Diversität bei scieneers

Am 28.05. ist der Deutsche Diversity Tag, der von dem Charta der Vielfalt e.V. initiiert wurde. Für uns scieneers hat Vielfalt einen sehr hohen Stellenwert und bildet das Fundament für den Umgang untereinander und mit unseren Kund:innen. Deswegen haben wir uns dazu entschieden, die Charta der Vielfalt zu unterschreiben und damit unsere Diversitätsstrategie weiter auszubauen.

dpunkt.verlag GmbH

dpunkt.verlag GmbHM3 2024

Auf der diesjährigen Minds Mastering Machines (M3) Konferenz in Köln standen neben den neuesten Trends im Bereich Machine Learning besonders Sprachmodelle (LLM), aber auch der AI Act, AI Fairness und automatische Datenintegration im Fokus. Wir waren mit zwei talks zu unseren Projekten beteiligt.

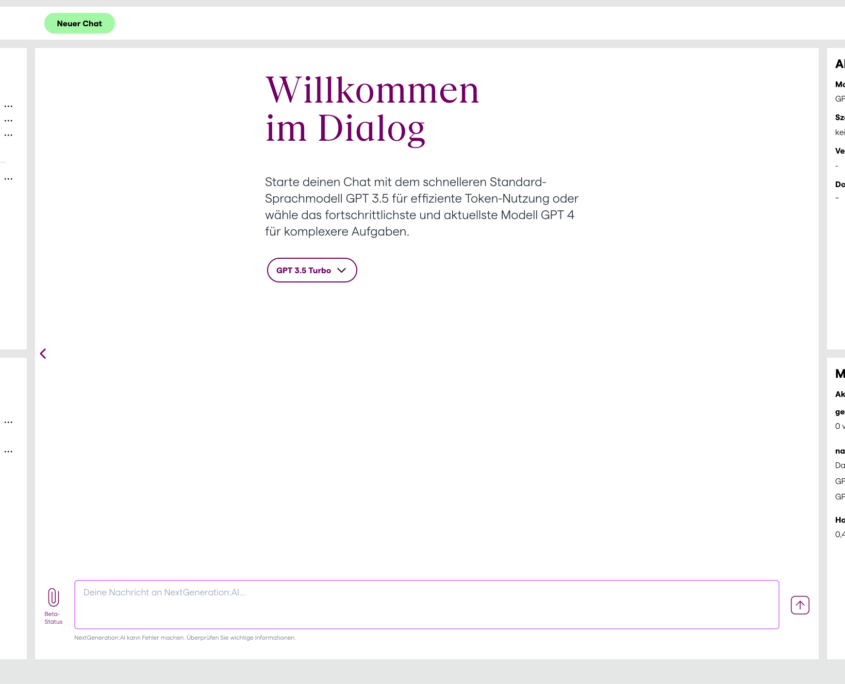

NextGeneration:AI – Innovation trifft Datenschutz

Zusammen mit der Carl Remigius Fresenius Education Group (CRFE) entwickelten wir NextGeneration:AI. Dabei handelt es sich um eine datenschutzkonforme Plattform zur Nutzung von Sprachmodellen für alle Studierende und Mitarbeitende der CRFE. Das besondere an NextGeneration:AI ist die Authentifizierung über das Learning Management System Ilias mit Hilfe einer LTI-Schnittstelle, sowie die umfassende Personalisierbarkeit, die Nutzer:innen geboten wird. Im Blogartikel gehen wir auf die Details der Implementierung ein.

Multi-Agenten-LLM-Systeme kontrollieren mit LangGraph

Im zweiten Teil der Reihe zu Multi-Agenten-Systemen werfen wir einen Blick auf LangGraph auf dem LangChain Ökosystem. LangGraph ermöglicht eine dynamische Kommunikation der Agenten die Mittels eines Graphen modelliert wird. Der Artikel vergleicht außerdem LangGraph mit AutoGen mit Blick auf Projektstatus, Nachrichtenfluss, Usability und Produktreife.

Eine Einführung in Multi-Agent-AI mit AutoGen

Der Blogpost diskutiert die Anwendung von Multi-Agenten-Systemen in der Künstlichen Intelligenz und ihre Implementierung mit Autogen, einem Framework für solche Systeme. Es werden die Bausteine von Multi-Agenten-Systemen erläutert und der Nutzen von mehreren, spezialisierten Agenten in bestimmten Aufgabenbereichen aufgezeigt. Das Konzept und die Verwendung von Autogen werden im Detail beleuchtet. Ebenfalls thematisiert werden die Herausforderungen bei der Steuerung von Informationsflüssen und die Notwendigkeit von spezialisierten Tools.

Power BI Sicherheit: Wie Power Apps die Verwaltung von Row-Level-Security auf das nächste Level hebt

Das Konzept der Row-Level-Security (RLS) in Power BI ermöglicht die Kontrolle des Datenzugriffs auf Zeilenebene. Dieser Artikel erklärt die Implementierung von RLS und die damit verbundenen Herausforderungen. Es wird eine Lösung durch die Entwicklung von Security-Tabellen und die Pflege über eine grafische Oberfläche wie Power Apps vorgestellt, die eine effiziente und fehlerfreie Verwaltung von Zugriffsrechten ermöglicht.

Die fünf Schritte des Power BI-Workflows: Ein praktischer Leitfaden mit Tipps

In einer datengetriebenen Welt, in der die Entscheidungsfindung auf der Analyse von Daten beruht, ist das Konzept der Self-Service-Business Intelligence (BI) sehr wertvoll. Mit der Fülle an Informationen, die Unternehmen täglich sammeln, ist es ein entscheidender Vorteil für Mitarbeitende, selbstständig und auf einfache Art datengestützte Einsichten zu generieren. Hier kommt Power BI ins Spiel, ein leistungsstarkes Business Intelligence -Tool von Microsoft. Dieser Blog-Artikel stellt den typischen Power BI-Workflow in fünf Schritten vor, beschreibt die Umsetzung im Detail und gibt Tipps für jeden Schritt.

Erforschung des Dark Genome mit Machine Learning zur Entwicklung neuartiger Krankheitsinterventionen

350 Millionen, fast 5% der Weltbevölkerung leben mit einer seltenen Erkrankung. Etwa 75% der seltenen Erkrankungen betreffen Kinder. 80% dieser Erkrankungen entstehen durch eine einzige genetische Veränderung und können durch eine Genomanalyse diagnostiziert werden. Das menschliche Genom besteht aus etwa 3.3 Milliarden Bausteinen und jeder Mensch trägt etwa 3.5 Millionen Varianten. Die Suche nach der einen, pathogenen Variante, als Ursache der Krankheit, gleicht der Suche nach der Nadel im Heuhaufen.

Personalisierte Stellenausschreibungen durch LLMs auf Grundlage einer Personenbeschreibung

In unserem Blogartikel zur Individualisierung von Konferenz-Programmen durch LLMs zeigen wir bereits einen Anwendungsfall von Textpersonalisierung durch den Einsatz von LLMs. Neben dem Individualisieren von Konferenz-Programmen anhand gegebener Interessen und Kenntnisse existieren weitere Anwendungsfälle im Bereich der personalisierten Generierung von Text. Daher haben wir die Personalisierung von Stellenausschreibungen durch LLMs anhand einer kurzen Personenbeschreibung getestet.

IT-Tage 2023

Erstmals durften wir bei den IT-Tagen 2023 im Dezember in Frankfurt dabei sein. Die Konferenz bietet einen vielfältigen Einblick in die IT-Welt, von Software-Architektur über Agile-Praktikten bis zum zu großen Sprachmodellen. Wir trugen mit zwei Vorträgen zu Unit-Testing und Personalisierung mit LLMs spannende Themen für Data Scientists bei.

rwthGPT – Eine datenschutzkonforme Plattform für OpenAI-Modelle

Zusammen mit der RWTH Aachen University haben wir rwthGPT entwickelt: Eine datenschutzkonforme Plattform zur Nutzung von OpenAI-Modellen für Studierende und Mitarbeitende. Ergänzt wird rwthGPT durch ein dediziertes User-Management mit Kostenzuordnung, das Speichern von Chat-Verläufen und Talk to your Data. Wir werfen einen detaillierten Blick auf die Datenschutz-relevanten Aspekte.

data2day 2023

Auf der data2day 2023 im Oktober in Karlsruhe wurden die neuesten Datenanalyse-Technologien anhand von Datenprojekten diskutiert. Neben Data Mesh und großen Sprachmodellen (LLMs) stellten Martin Danner und Jan Höllmer scieneers-Projekte mit Temporal Fusion Transformer (TFT) zu Prognose und Anomalie-Erkennung bei Iqony vor.

Data Platform auf Azure – aber bitte sicher!

Viele Unternehmen nutzen inzwischen die Azure Data Services für Data Management und Analytics Aufgaben oder planen den Umstieg auf Microsofts Cloud Platform. Viele Gründe wie Betriebskosten und Skalierbarkeit sprechen dafür, aber wie ist es um die Sicherheit bestellt? In dem Vortrag schauen wir uns an, welche Mechanismen auf Azure zum sicheren Datenaustausch genutzt werden können. wie der Datenzugriff von Dienste- bis bis auf Datenebene für Endbenutzer konfiguriert werden kann und welche Möglichkeiten es gibt, die Services netzwerktechnisch sicher zu verbinden und gleichzeitig vor unerwünschten Besuchern abzuschotten.

Optimize an AI Powered Recommendation Engine

scieneers, Intel Corporation, and Von Rundstedt joined forces to optimize an AI powered recommendation engine solution that leverages the Intel® AI Analytics Toolkit and 4th Generation Intel® Xeon® Scalable Processors. In this brief experience report we demonstrate how we managed to achieve up to 9.3X speedup when running on 4th Generation Intel® Xeon® Scalable Processors compared to the baseline configuration. This means that the solution can process more data faster, generate more accurate recommendations, and serve more users with lower latency and cost.

LLMs und Cloud-Technologien zur Vernetzung von Onlineshops der Otto-Gruppe

Large Language Models (LLMs) sind wegen ihrer vielfältigen Anwendungen in aller Munde. Auch im E-Commerce Bereich ist diese Technologie sehr nützlich. Zusammen mit der data.works GmbH haben wir sogenannte Embedding-Modelle aus dem LLM-Bereich mit der Vertex AI Matching Engine in der Google Cloud für mehrere Onlineshops der Otto-Gruppe eingesetzt, um kundenspezifische Produktempfehlungen aus einem Shop auf viele andere Shops übertragen zu können. Und das, obwohl sich die Sortimente und Kataloge dieser Shops stark unterscheiden.

Wärmebedarf prognostizieren mit Temporal Fusion Transformern

Zusammen mit Iqony haben wir den Einsatz von Temporal Fusion Transformern zur Bedarfsprognose in der Fernwärme getestet. Durch Data Fusion können die Vorhersagen von mehreren Standorten in einem Modell vereint und vor allem die Vorhersagegenauigkeit von Standorten mit wenig Daten gesteigert werden. Die Quantisierung von Vorhersageunsicherheiten und die Interpretierbarkeit des Modells schaffen Vertrauen und unterstützen die Entscheidungsfindung.

Moodle Chatbot – KI als persönlicher Uni-Dozent

Zusammen mit der RWTH Aachen haben wir einen Chatbot entwickelt, der einen nahtlosen Zugang zu Vorlesungsinhalten für Studierende und Mitarbeitende direkt in der Lernplattform Moodle ermöglicht. Somit können themenspezifische Fragen mit Inhalten aus einer Vorlesung beantwortet werden. Eine zusätzliche Quellenangabe erlaubt außerdem das schnelle Finden der relevanten Vorlesungsinhalte in den Unterlagen.

KI-basierte Textanalyse für die Energiewirtschaft

Künstliche Intelligenz (KI) erfährt durch ChatGPT derzeit enorme Aufmerksamkeit. Abseits vom Hype haben die aktuellsten Entwicklungen die Verarbeitung von Sprache und Texten auf ein neues Niveau gehoben. In diesem Artikel wollen wir Ihnen zeigen, was ChatGPT & Co. im Kontext der Energiewirtschaft wirklich leisten können, was das Neue daran ist und wie man diese Tools in der Praxis einsetzen kann.

Anomalieerkennung bei Windkraftanlagen mit Temporal Fusion Transformern für Iqony

Transformer-Architekturen haben sich als bahnbrechend im Bereich des Natural Language Processing erwiesen. Temporal Fusion Transformer nutzen diese Architektur für die Prognose von Zeitreihen und bieten dabei gegenüber klassischen Modellen Vorteile wie z.B. hohe Interpretierbarkeit und Data Fusion. Mit iqony hatten wir nun die Möglichkeit dieses Modell in der Praxis für die Anomalieerkennung bei Windkraftanlagen zu testen.

Mit scikit-learn Modelle erstellen

Um Einsteiger:innen einen Überblick über die Möglichkeiten von scikit-learn zu geben, haben wir im kürzlichen erschienenen ix-Sonderheft "Künstliche Intelligenz" einen Artikel zum Thema "Mit scikit-learn Modelle erstellen" veröffentlicht.

Minds Mastering Machines 2023

Auf der diesjährigen M3-Konferenz haben wir in drei Vorträgen unsere Erkenntnisse und Erfahrungen präsentiert: Polars, eine alternative Datenbearbeitungs-Bibliothek zur bekannten Pandas-Bibliothek, sowie Einblicke, in die Realisierung präziser Wärmebedarfsprognosen mit Transformer-Modellen und die Optimierung Neuronaler Netze mit Open-Source-Bibliotheken.

scieneers at PyCon DE & PyData Berlin 2023

At this year’s PyCon DE & PyData Berlin, we presented our learnings and experiences in two talks: Polars, an alternative data-wrangling library to the well-known Pandas library and in a second talk insights we gained from building an internal QA-Chat system, even before ChatGPT and it's buzz started.

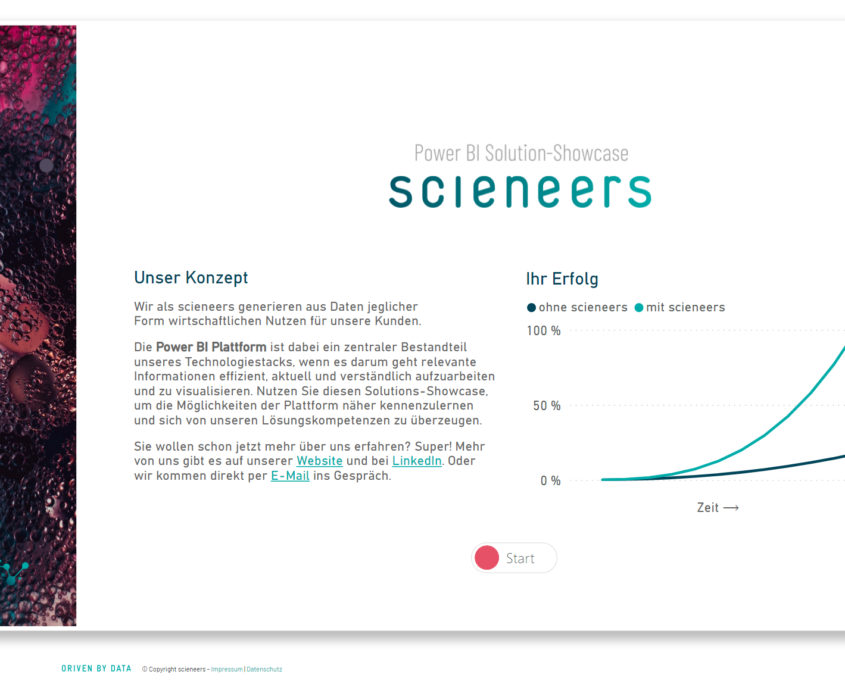

Einführung in Microsofts Power BI Plattform

Power BI ist ein fester Bestandteil unseres Technologiestacks, weshalb wir in diesem Artikel eine kurze Power BI Einführung geben wollen.

Kooperation SCHOTT AG – scieneers: MIP Reporting mit Power BI

Kooperation Schott AG mit scieneers shopfloor Daten Reporting in Power BI auf Basis der MIP Platform von MPDV

Wie implementiere ich einen “Question Answering”-Bot für Slack in Python?

Basierend auf unseren internen Dokumenten und Chat-Gesprächen haben wir mit open-source Technologien ein System gebaut, welches den Zugriff auf internes Wissen vereinfacht. Hier geben wir einen detailierten Einblick im die Implementierung.

scieneers

scieneersEinführung in Unittesting mit Python für Data Scientists

Unittests können in Data-Science-Projekten sehr sinnvoll sein, um eine hohe Codequalität sicherzustellen. Um den Einstieg in das Unittesten mit Python für Data Scientists zu erleichtern, haben wir einen Artikel zu diesem Thema geschrieben, der auf Informatik Aktuell veröffentlicht wurde.

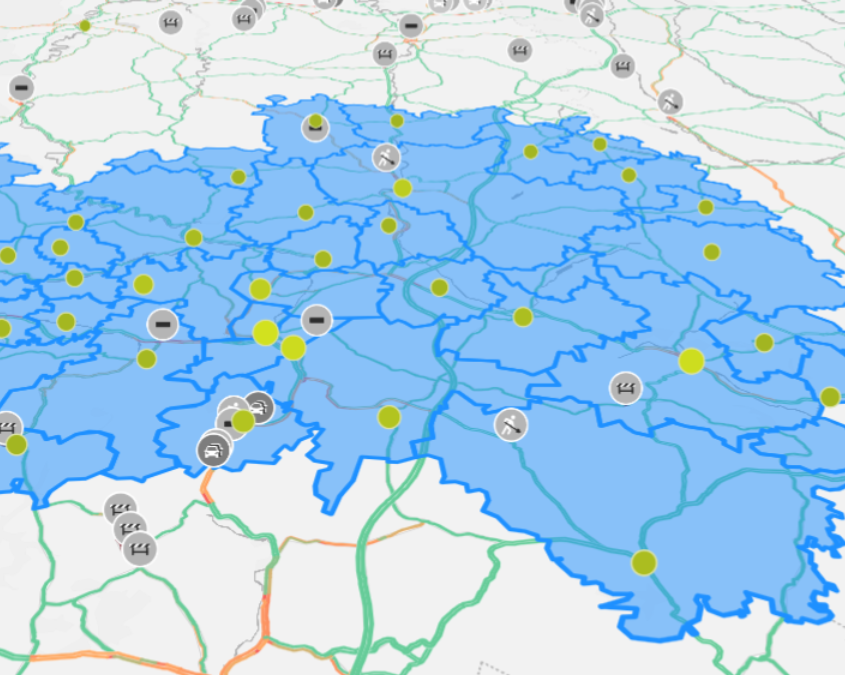

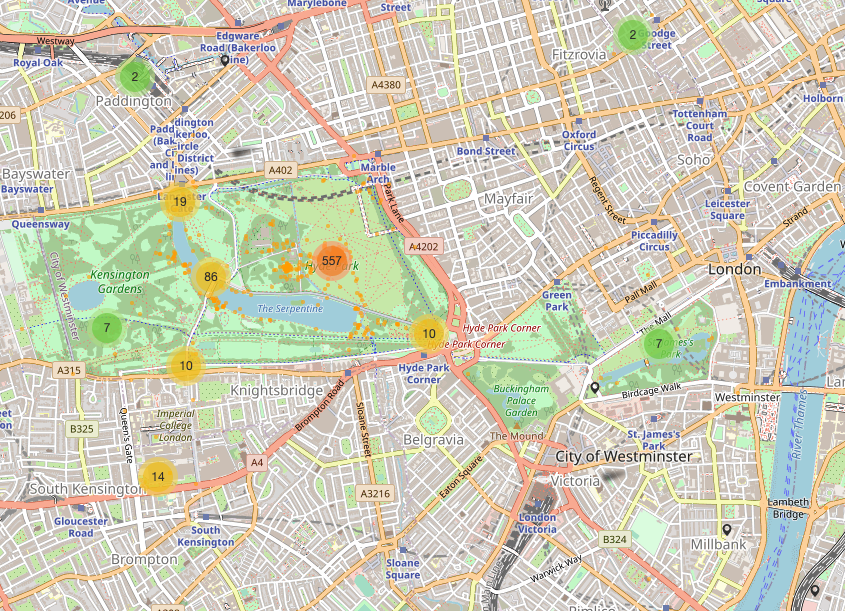

Explorative Geodaten-Analyse mit Power BI bei Ämtern und Behörden

Gemeinsame Entwicklung eines vollständig nutzbaren Prototypen zur ansprechenden Visualisierung von Daten aus verschiedenen Fachverfahren des öffentlichen Dienstes auf Landkarten. Die Dashboards ermöglichen es, schnell und interaktiv Zusammenhänge zu erkennen, aus denen sich mögliche Maßnahmen daten- und faktenbasiert ableiten und begründen lassen.

Entwicklung nach SCRUM und CRISP-DM am Fallbeispiel Wärmeprognose bei STEAG New Energies

Am Fallbeispiel der Wärmeprognose bei STEAG New Energies wird die Entwicklung und das Projektvorgehen nach SCRUM und CRISP-DM skizziert. Neben der detaillierten Beschreibung der einzelnen Schritte einer Entwicklungsiteration, liegt ein weiterer Fokus des Blog-Artikels auf dem im Einsatz befindlichen Technologie-Stack.

Free for commercial use, photo by Kevin Ku on Unsplash

Free for commercial use, photo by Kevin Ku on UnsplashEffektive Code Reviews für Data-Science-Projekte

Code Reviews sind eine gängige Praxis in der Softwareentwicklung, doch sie sind auch in Data-Science-Projekten relevant und sinnvoll. Der Artikel beleuchtet die Gründe dafür und gibt Hinweise darauf, wie Code Reviews in Data-Science-Projekten effektiv gestaltet werden können.

SQLDays – Vortrag Azure Data Factory 2022 – whats new?

SQLDays 2022 - Folien zum Vortrag von Stefan Kirner zu Neuigikeiten in der Azure Data Factory und Synapse Pipelines und ein Vergleich der Technologien.

Adi Goldstein

Adi GoldsteinKooperation mit Intel®: Quantisierung von ML-Modellen und Performance-Boost im Pre-Processing

scieneers sind AI Specialist Partner des Halbleiterhersteller Intel®. Wir erproben in realen Einsatzszenarien, wie durch Intels neueste Technologien und Tools die Performance analytischer Modelle und Berechnungen auf großen Datenmengen weiter gesteigert werden können

Tipps & Tricks bei der Entwicklung eines Dashboards mit Streamlit & Plotly

Wir haben mit Streamlit und plotly.express ein web-basiertes Dashboard für die Übersicht über CO2-Emissionen gebaut. Dieser Blogeintrag zeigt einige Tipps und Tricks, die wir bei der Implementierung und dem Deployment des Dashboards gelernt haben.

informatica feminale Baden-Württemberg 2022 – ein Rückblick

Dieses Jahr fand die informatica feminale Baden-Württemberg an der technischen Fakultät der Universität in Freiburg statt, und wir scieneers durften dort mit einem Kurs zum Thema "Visualisierungsframeworks in Python" das Angebot für die Teilnehmerinnen mitgestalten.

Konferenz-Rückblick: DataLift Summit

Rückblick zur Konferenz DataLift Summit und Informationen zum dort gehaltenen Workshop zu visueller Datenexploration mit Python

Partnerschaft MPDV – scieneers: MIP smart factory Daten in Power BI

Wir ergänzen die smart factory Plattform MIP unseres Partners MPDV um ein Basis-Lösungspaket in Power BI und der Expertise, auch kundenspezfische Anforderungen sehr schnell in KPIs und Visuals umzusetzen.

PASS Camp 2022 – Ein Einblick

Das PASS Camp fand nach zweijähriger Corona-Pause endlich wieder statt und auch wir waren dabei. In unserem Blog geben wir Euch einen kurzen Einblick.

Steag New Energies GmbH

Steag New Energies GmbHVoll auf Kurs: optimierte Energieerzeugung dank KI

Datenoptimierte Wärmeprognosen und Fahrplanerzeugung bei KWK-Anlagen - unser spannendes Azure-Daten-Projekt mit Steag New Energies wird hier vorgestellt

Frühlingserwachen 2022

Zwei Tage lang haben wir uns in unserem Kölner Office zusammengefunden, um uns in vier Formaten über fachliche und persönliche Themen auszutauschen und das bisher Erreichte bis in die Abendstunden zu feiern.

BI Consultant Getting Started mit PySpark Notebooks

First steps um als BI Consultant Python zu lernen und in die Ladeprozesse zu integrieren am Beispiel Azure Synapse

Photo courtesy of Lwala Community Alliance

Photo courtesy of Lwala Community AllianceGood data quality can save lives

In a pro-bono project facilitated by DataKind we had the great opportunity to join a team of volunteer data scientists to enable the Lwala Community Alliance to monitor the quality of their data.

Our talks at PyCon DE/PyData Berlin

At this year’s PyCon DE & PyData Berlin, we presented our learnings and experiences in two talks. These covered very different aspects of data work: On the one hand, we showcased predictive modeling applications in wind turbine maintenance and the challenges of anomaly detection. In a different presentation, we explained why code reviews are still important for data science tasks and how we can apply them to benefit from the effort.

Live Demo: MIP Daten in Power BI

Live-Demo mit smart factory Shopfloor-Daten verschiedener Maschinen die über die Integrationsplattform MIS von mpdv nach Power BI

Review 2021

Wieder ein Jahr mit Corona. Aber auch wieder ein Jahr, in dem wir große Erfolge feiern durften.

Power BI Solution Deutsch

Die Power BI Plattform ist ein zentraler Bestandteil unseres Technologiestacks, wenn es darum geht relevante Informationen effizient, aktuell und verständlich aufzuarbeiten und zu visualisieren. Nutzen Sie diesen Solutions-Showcase, um die Möglichkeiten der Plattform näher kennenzulernen und sich von unseren Lösungskompetenzen zu überzeugen.

Reicht auch Power BI only für mein Projekt?

Fragt sich so mancher Entwickler angesichts immer mehr Funktionsumfang und Enterprise Readyness auf Seiten Microsoft Power BI. Normalerweise beinhalten BI Projekte spezialisierten Komponenten wie zur Persistenz (Datenbanken, Data Lake & co.) oder für ETL. Power BI deckt den kompletten Bereich einer BI Lösung ab. Aber gibt es Dinge die gar nicht gehen in Power BI, wo sind Schwächen und gibt es das typische Power BI Projekt? Dieses spannende Thema wird in der Session diskutiert!

User Behavior in iNaturalist’s City Nature Challenges

At scieneers, social engagement is an important goal that we pursue with value-creating and sustainable projects. We are particularly interested in using our knowledge of data and our technical skills for "data for good" projects and sharing them with others. The following project from the CorrelAid network aims to investigate the internal dynamics of citizen science communities, in particular how users of such communities behave and what roles they take.

Wie finde ich eine zu mir passende Stelle?

Du weißt, dass du im IT Bereich arbeiten möchtest, fragst dich aber, wie du eine Stelle findest, bei der du glücklich wirst?

Genau diese Frage hat mich vor einem Jahr beschäftigt. Nach einem Quereinstieg als Software Entwicklerin stellte ich nach einem guten Jahr Berufserfahrung Unzufriedenheit fest. Um der Ursache auf den Grund zu gehen, befasste ich mich damit, was mir in meinem Job eigentlich wichtig ist -- basierend auf meinen bisherigen Erfahrungen in Studium, Praktika und Beruf.

Realtime Data Integration mit Azure Service Bus & Azure Logic Apps & Dataverse

Realtime Data Integration mit Azure Service us & Azure Logic Apps & Dataverse

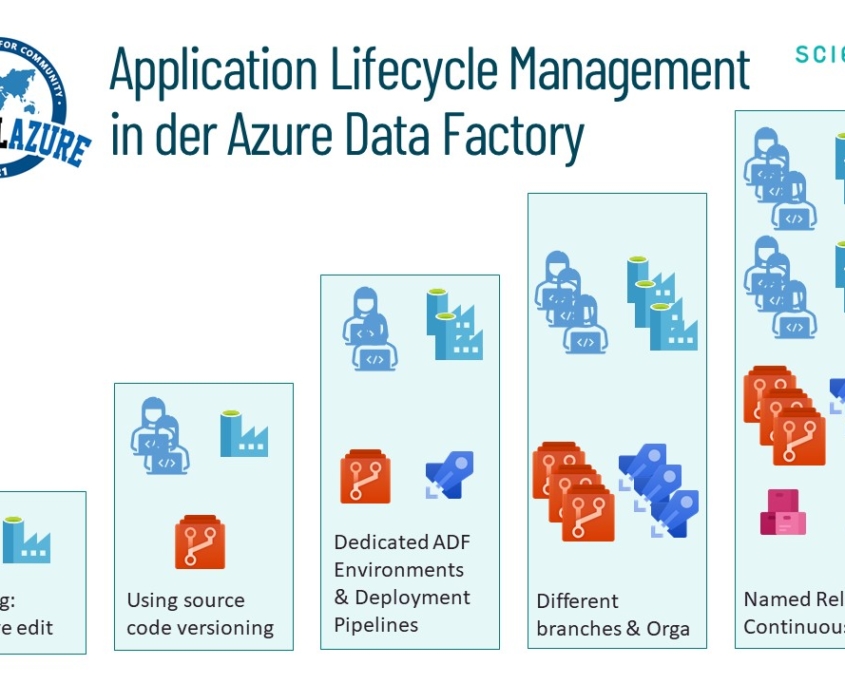

Application Lifecycle Management in der Azure Data Factory

Vorstellung von Methoden, Technologien und Best Practices wie man in der Azure Data Factory strukturiert und sicher entwickeln kann, in dem man die Integration und Dienste von Azure DevOps nutzt

Künstliche Intelligenz in der Betriebsoptimierung von erneuerbaren Erzeugungsanlagen bei der EnBW

Die Künstliche Intelligenz und das Maschinelle Lernen wird immer mehr zu einem alltäglichen Begleiter und hält somit auch Einzug in die Energie-Branche. Im Rahmen eines Projekts bei der EnBW stellten wir Untersuchungen zu dem bereits implementiertem Predictive Maintenance System, das Schäden in Erzeugungsanlagen rechtzeitig erkennen soll, an und testeten zusätzlich neuere Algorithmen zur rechtzeitigen Schadenserkennung in Windkraftanlagen.

Advanced security of PaaS based Azure data applications – from setup to ALM

I want to share my experience from my projects of creating data applications from a security perspective, covering cloud infrastructure and application parts, as well as application lifecycle challenges during CI/CD. We‘ll go through examples how to handle secrets savely and manageable and configure Azure resources with diverse security concepts.

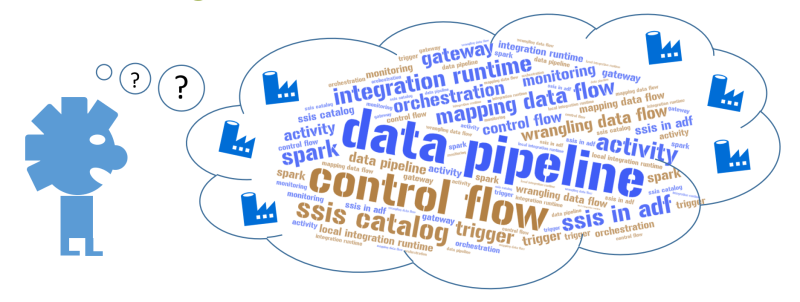

Data engineering pattern in der Azure Data Factory

In dem Vortrag werden die typischen Muster für Datenverarbeitung in der Azure Data Factory aufgezeigt und verglichen. Das wird abgerundet mit best practices zum Application Lifecylce Management.

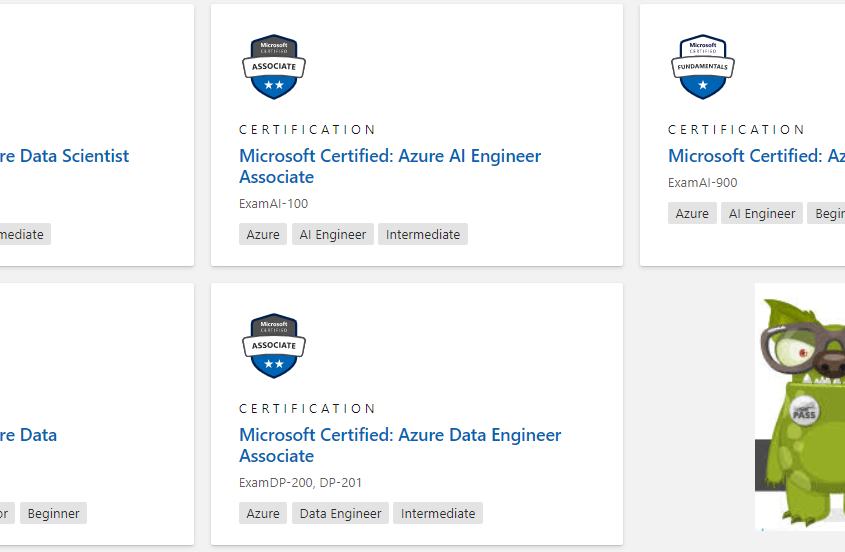

Microsoft Certified Data Monster

In der Aufzeichnung sprechen MVP Frank Geisler und Stefan Kirner über Microsoft Zertifizierungen im Allgemeinen und insbesondere für die Data Platform.

Warum sollte ich mich damit beschäftigen?

Was gibt es für Zertifizierungen von MS im Data Bereich?

Wie geht das mit der Anmeldung?

Wie bereite ich mich darauf vor?

Wie läuft so eine Prüfung ab?

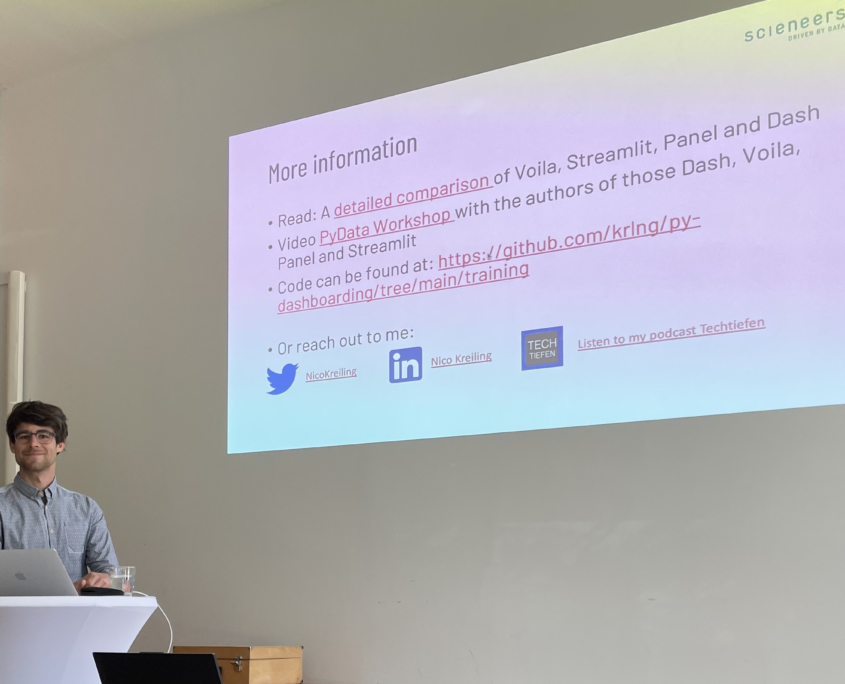

Professionelles Arbeiten mit Jupyter Notebooks/Lab

Materialien zum Vortrag Professionelles Arbeiten mit Jupyter Notebooks/Lab von Nico Kreiling

Five shades of dataflow

Talk is an overview of the "shades" of data flows in Power Platform and Azure Data Factory, their purpose and of course the technologies

Daten-Grundlagenarbeit in Python

Die erfolgreiche Umsetzung von Daten-Projekten erfodert einen gekonnten Umgang mit den elementaren Werkzeugen. Für das Heise Machine Learning Sonderheft haben wir eine Einführung in PyData Tools wie NumPy, Pandas und Scikit-Learn geschrieben.

Ein kurzer Blick zurück

Ein turbulentes Jahr neigt sich dem Ende entgegen. Ein Jahr, in dem Corona praktisch alles überschattet hat. Dennoch können wir voller Dankbarkeit auf ein sehr erfolgreiches erstes Geschäftsjahr zurückblicken.

The political discourse on discrimination – how to use natural language processing for good

At this year’s CorrelCon, we presented our work in the OpenDiscourse project. Leveraging techniques from natural language processing, we analyzed the speeches held in the Bundestag.

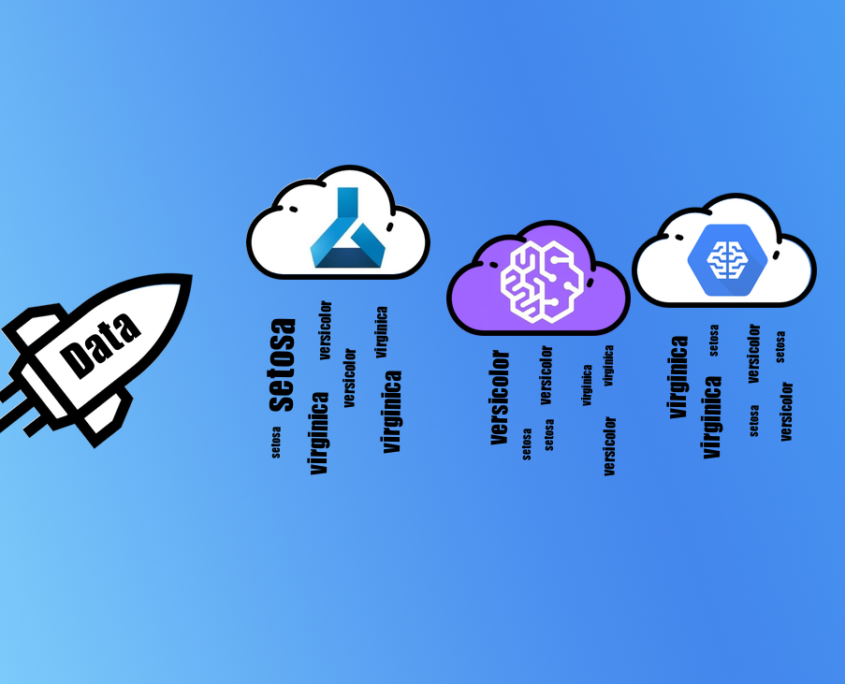

AutoML – A Comparison of cloud offerings

AutoML is the process of automatically applying machine learning to real world problems, which includes the data preparation steps such as missing value imputation, feature encoding and feature generation, model selection and hyper parameter tuning. Even though the research field on AutoML exists at least since its first dedicated workshop at ICML in 2014, real world usage just got applicable recently. This blog post compares the AutoML offerings of AWS, Google and Microsoft in a qualitative fashion.

Die scieneers community wächst!

Wir freuen uns sehr, dass sich die ersten Kolleginnen und Kollegen für die scieneers begeistern konnten. Mit diesem Team stellen wir uns gerne jeder Herausforderung, die das Daten-Business für uns bereit hält! Wo ihre Schwerpunkte liegen und was sie antreibt können sie selbst am besten beschreiben:

Was ist die Microsoft Data Platform?

Der Begriff steht im Allgemeinen für das Angebot an Data Management und Analytics Lösungen, die Microsoft klassisch für das Rechenzentrum des Kunden und in der Azure Cloud anbietet. Aber was beinhaltet das genau? Welche Tools sind gemeint und was gehört zusammen? Im Folgenden werden diese Möglichkeiten in drei verschiedene technologische Bereiche eingeteilt, inhaltlich beschrieben und grob abgegrenzt.

Der Anfang ist gemacht.

Nach den ersten Wochen am Markt ziehen wir schon mal ein erstes positives Fazit: Die ersten Kunden und Partner konnten wir für uns gewinnen.

Hello World, wir sind die scieneers! Wir sind “driven by data”.

Zugegeben, es ist nicht die beste Zeit, um mit einem neu gegründeten Unternehmen an den Markt zu gehen. Wir haben uns entschieden es trotzdem zu tun. Warum wir überzeugt sind, dass es trotz oder gerade wegen Corona der richtige Schritt ist, möchten wir Euch mit diesem Blogpost kurz erklären.