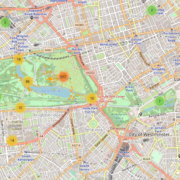

User Behavior in iNaturalist’s City Nature Challenges

At scieneers, social engagement is an important goal that we pursue with value-creating and sustainable projects. We are particularly interested in using our knowledge of data and our technical skills for „data for good“ projects and sharing them with others. The following project from the CorrelAid network aims to investigate the internal dynamics of citizen science communities, in particular how users of such communities behave and what roles they take.