https://www.scieneers.de/wp-content/uploads/2025/02/Output-desinfonavigator_0.png

914

1672

Nico Kreiling

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

Nico Kreiling2025-02-21 11:03:012025-02-21 14:57:12DesinfoNavigator

https://www.scieneers.de/wp-content/uploads/2025/02/Output-desinfonavigator_0.png

914

1672

Nico Kreiling

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

Nico Kreiling2025-02-21 11:03:012025-02-21 14:57:12DesinfoNavigator https://www.scieneers.de/wp-content/uploads/2025/02/Output-desinfonavigator_0.png

914

1672

Nico Kreiling

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

Nico Kreiling2025-02-21 11:03:012025-02-21 14:57:12DesinfoNavigator

https://www.scieneers.de/wp-content/uploads/2025/02/Output-desinfonavigator_0.png

914

1672

Nico Kreiling

https://www.scieneers.de/wp-content/uploads/2020/04/scieneers-gradient.png

Nico Kreiling2025-02-21 11:03:012025-02-21 14:57:12DesinfoNavigator

Benefits bei scieneers

Scieneers bietet ein attraktives Arbeitsumfeld mit flexiblen Arbeitszeiten, Home-Office, Kita-Zuschuss, Mitarbeiter-Events, Weiterbildungsbudgets, Mitarbeiterbeteiligung, betrieblicher Altersvorsorge und moderner Technik. Inklusion, Transparenz und Nachhaltigkeit prägen die Firmenkultur, die Diversität und Teamgeist fördert.

KI trifft Datenschutz: Unsere ChatGPT-Lösung für Unternehmenswissen

Unsere ChatGPT-Lösung ermöglicht es Unternehmen, firmeninternes Wissen sicher und datenschutzkonform zu nutzen. Mittels eines modularen Systems, das auf unternehmensspezifische Datenquellen wie SharePoint und OneDrive zugreift, können Mitarbeiter schnell und einfach auf Informationen zugreifen. Die Lösung bietet personalisierte Budgetverwaltung, sichere Authentifizierung und eine anpassbare Benutzeroberfläche, inklusive Feedback-Mechanismen für kontinuierliche Verbesserungen.

Wie Studierende von LLMs und Chatbots profitieren können

In der Hochschulbildung revolutionieren Large Language Models (LLMs) und Retrieval Augmented Generation (RAG) das Lernen. Ein Projekt der Universität Leipzig zeigt den Erfolg von KI-Tutoren im Jura-Studium, die personalisierte Antworten bieten und auf Ressourcen verweisen. Vorteile für Studierende und Lehrende sind maßgeschneiderte Unterstützung und effiziente Lehrmaterialentwicklung, trotz Herausforderungen wie Ressourcenbedarf und Antwortqualität. Azure und OpenAI unterstützen mit sicherer Infrastruktur.

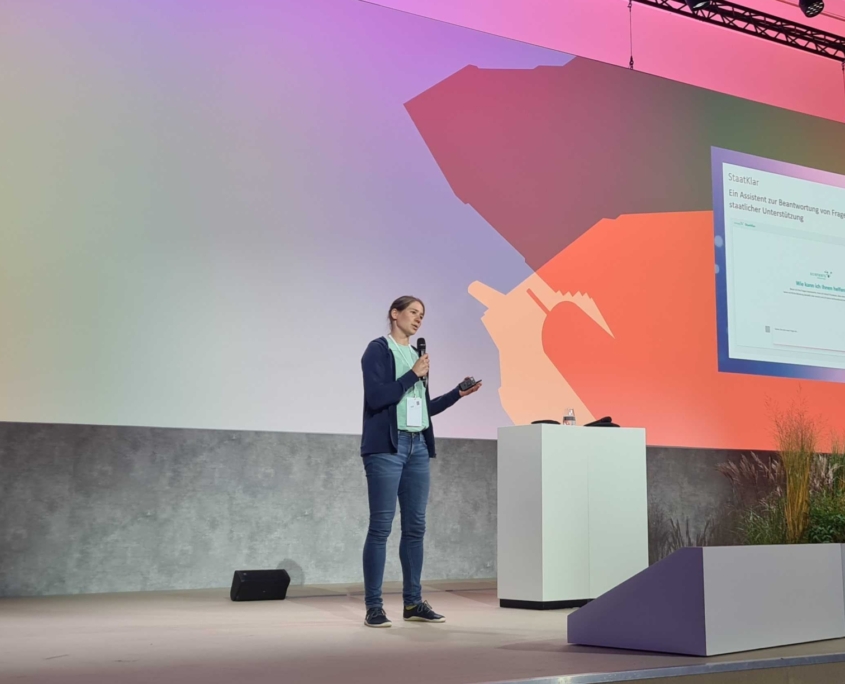

KI für das Gemeinwohl auf dem Digital-Gipfel 2024

Wir durften unser durch den Civic Coding-Accelerator gefördertes LLM-Projekt StaatKlar an Tag 2 des Digital-Gipfels 2024 vorstellen. Für alle Neugierigen hier eine kurze Zusammenfassung unseres Projekts und des Gipfels.

Der Einsatz von VideoRAG für den Wissenstransfer im Unternehmen

VideoRAG bietet einen innovativen Ansatz zur Überbrückung von Wissenslücken in Unternehmen, indem Video- und Textdaten mit Hilfe von generativer KI und Retrieval-Augmentation in eine durchsuchbare Wissensdatenbank umgewandelt werden. Es gewährleistet einen effizienten Transfer von nuanciertem Wissen, einschließlich des impliziten Wissens erfahrener Mitarbeiter, über KI-basierte Chatbots und macht es so auch jüngeren Generationen innerhalb der Belegschaft zugänglich.

Data Factory in Fabric – the good, the bad and the ugly

Data Factory in Fabric – das Gute, das Schlechte und das Hässliche: Vorträge auf SQL Konferenzen zeigen Entwicklungen der Microsoft Fabric Data Factory auf. Vorteile wie erweiterte Features und einfache Migration werden ebenso besprochen wie Herausforderungen, darunter mangelnde Effizienz bei kleinen Projekten und technische Mängel. Microsoft arbeitet an Verbesserungen dieser vielversprechenden Technologie.

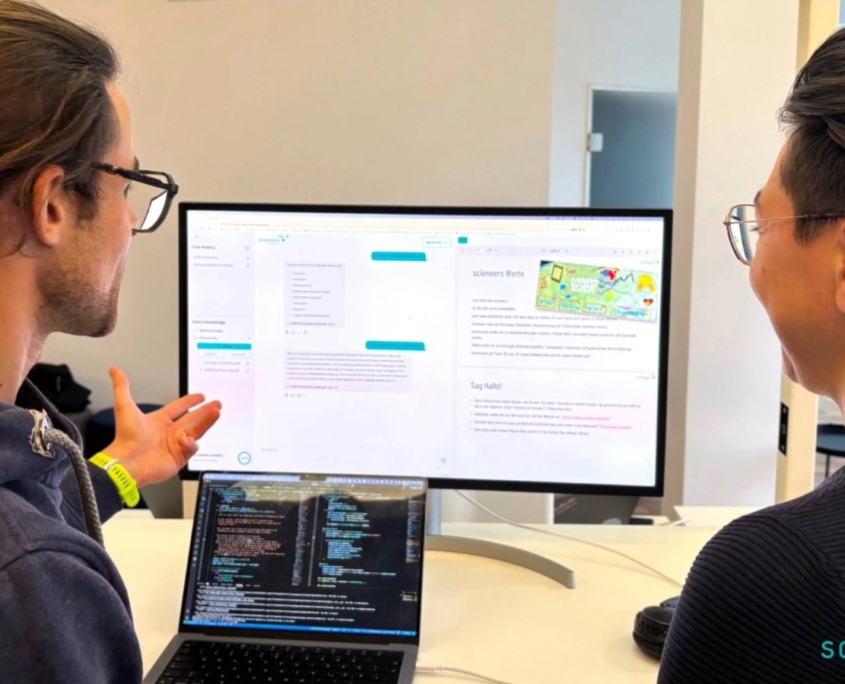

Multi-Agenten LLM auf der Data2Day

Auf der Data2Day Konferenz durften wir dieses Jahr zusammen mit Bertelsmann unser Multi-Agenten-LLM Projekt vorstellen. Für alle die nicht dabei waren, hier eine kleine Zusammenfassung unseres Vortrags und der sonstigen Konferenz-Highlights.

Logic App API Connections – Herausforderungen und Lösungswege in der Verwaltung

API-Connections sind entscheidend für Azure Logic Apps, um externe Dienste zu integrieren. Die Erstellung kann Verwaltungsherausforderungen mit unklaren Ressourcennamen mit sich bringen. Lösungswege umfassen manuelles Umbenennen über ARM-Templates und Automatisierung mit PowerShell, um die Verwaltung effizienter zu gestalten und die Einbindung in CI/CD-Prozesse zu erleichtern.

Diversity als Chance ➯ scieneers & Charta der Vielfalt

Wir, bei scieneers GmbH, verstehen die Rolle, die Diversity in der Arbeitswelt spielt und haben entsprechend die Charta der Vielfalt unterzeichnet.

European Society of Human Genetics

European Society of Human GeneticsEinblicke in die European Society of Human Genetics Konferenz 2024

Einblicke in die European Society of Human Genetics (ESHG) 2024 - eine beeindruckende, hybriden Veranstaltung, die Tausende von Besuchern aus aller Welt anlockte.

Diversität bei scieneers

Am 28.05. ist der Deutsche Diversity Tag, der von dem Charta der Vielfalt e.V. initiiert wurde. Für uns scieneers hat Vielfalt einen sehr hohen Stellenwert und bildet das Fundament für den Umgang untereinander und mit unseren Kund:innen. Deswegen haben wir uns dazu entschieden, die Charta der Vielfalt zu unterschreiben und damit unsere Diversitätsstrategie weiter auszubauen.

dpunkt.verlag GmbH

dpunkt.verlag GmbHM3 2024

Auf der diesjährigen Minds Mastering Machines (M3) Konferenz in Köln standen neben den neuesten Trends im Bereich Machine Learning besonders Sprachmodelle (LLM), aber auch der AI Act, AI Fairness und automatische Datenintegration im Fokus. Wir waren mit zwei talks zu unseren Projekten beteiligt.

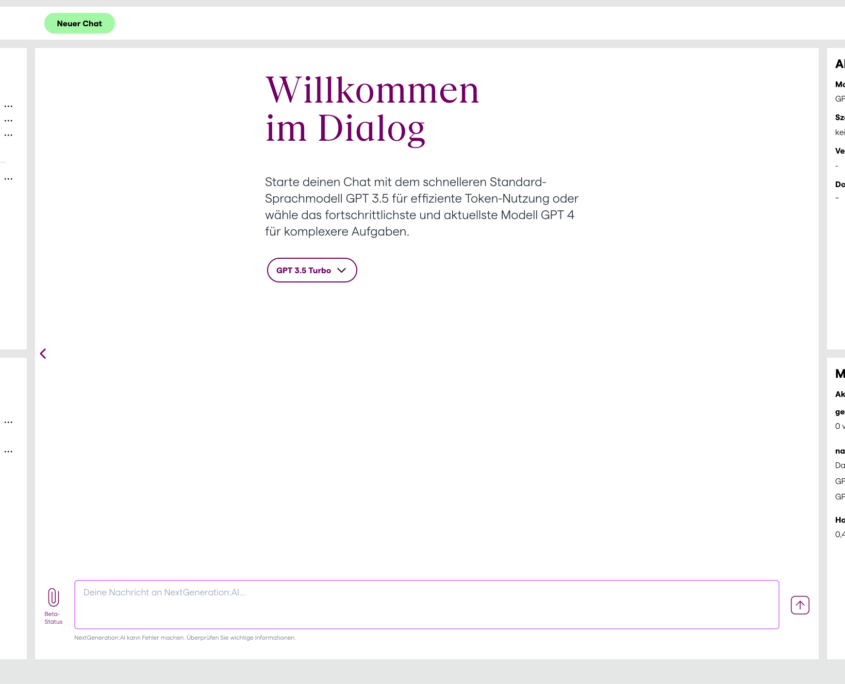

NextGeneration:AI – Innovation trifft Datenschutz

Zusammen mit der Carl Remigius Fresenius Education Group (CRFE) entwickelten wir NextGeneration:AI. Dabei handelt es sich um eine datenschutzkonforme Plattform zur Nutzung von Sprachmodellen für alle Studierende und Mitarbeitende der CRFE. Das besondere an NextGeneration:AI ist die Authentifizierung über das Learning Management System Ilias mit Hilfe einer LTI-Schnittstelle, sowie die umfassende Personalisierbarkeit, die Nutzer:innen geboten wird. Im Blogartikel gehen wir auf die Details der Implementierung ein.

Multi-Agenten-LLM-Systeme kontrollieren mit LangGraph

Im zweiten Teil der Reihe zu Multi-Agenten-Systemen werfen wir einen Blick auf LangGraph auf dem LangChain Ökosystem. LangGraph ermöglicht eine dynamische Kommunikation der Agenten die Mittels eines Graphen modelliert wird. Der Artikel vergleicht außerdem LangGraph mit AutoGen mit Blick auf Projektstatus, Nachrichtenfluss, Usability und Produktreife.

Eine Einführung in Multi-Agent-AI mit AutoGen

Der Blogpost diskutiert die Anwendung von Multi-Agenten-Systemen in der Künstlichen Intelligenz und ihre Implementierung mit Autogen, einem Framework für solche Systeme. Es werden die Bausteine von Multi-Agenten-Systemen erläutert und der Nutzen von mehreren, spezialisierten Agenten in bestimmten Aufgabenbereichen aufgezeigt. Das Konzept und die Verwendung von Autogen werden im Detail beleuchtet. Ebenfalls thematisiert werden die Herausforderungen bei der Steuerung von Informationsflüssen und die Notwendigkeit von spezialisierten Tools.

Power BI Sicherheit: Wie Power Apps die Verwaltung von Row-Level-Security auf das nächste Level hebt

Das Konzept der Row-Level-Security (RLS) in Power BI ermöglicht die Kontrolle des Datenzugriffs auf Zeilenebene. Dieser Artikel erklärt die Implementierung von RLS und die damit verbundenen Herausforderungen. Es wird eine Lösung durch die Entwicklung von Security-Tabellen und die Pflege über eine grafische Oberfläche wie Power Apps vorgestellt, die eine effiziente und fehlerfreie Verwaltung von Zugriffsrechten ermöglicht.

Die fünf Schritte des Power BI-Workflows: Ein praktischer Leitfaden mit Tipps

In einer datengetriebenen Welt, in der die Entscheidungsfindung auf der Analyse von Daten beruht, ist das Konzept der Self-Service-Business Intelligence (BI) sehr wertvoll. Mit der Fülle an Informationen, die Unternehmen täglich sammeln, ist es ein entscheidender Vorteil für Mitarbeitende, selbstständig und auf einfache Art datengestützte Einsichten zu generieren. Hier kommt Power BI ins Spiel, ein leistungsstarkes Business Intelligence -Tool von Microsoft. Dieser Blog-Artikel stellt den typischen Power BI-Workflow in fünf Schritten vor, beschreibt die Umsetzung im Detail und gibt Tipps für jeden Schritt.

Erforschung des Dark Genome mit Machine Learning zur Entwicklung neuartiger Krankheitsinterventionen

350 Millionen, fast 5% der Weltbevölkerung leben mit einer seltenen Erkrankung. Etwa 75% der seltenen Erkrankungen betreffen Kinder. 80% dieser Erkrankungen entstehen durch eine einzige genetische Veränderung und können durch eine Genomanalyse diagnostiziert werden. Das menschliche Genom besteht aus etwa 3.3 Milliarden Bausteinen und jeder Mensch trägt etwa 3.5 Millionen Varianten. Die Suche nach der einen, pathogenen Variante, als Ursache der Krankheit, gleicht der Suche nach der Nadel im Heuhaufen.

Personalisierte Stellenausschreibungen durch LLMs auf Grundlage einer Personenbeschreibung

In unserem Blogartikel zur Individualisierung von Konferenz-Programmen durch LLMs zeigen wir bereits einen Anwendungsfall von Textpersonalisierung durch den Einsatz von LLMs. Neben dem Individualisieren von Konferenz-Programmen anhand gegebener Interessen und Kenntnisse existieren weitere Anwendungsfälle im Bereich der personalisierten Generierung von Text. Daher haben wir die Personalisierung von Stellenausschreibungen durch LLMs anhand einer kurzen Personenbeschreibung getestet.

IT-Tage 2023

Erstmals durften wir bei den IT-Tagen 2023 im Dezember in Frankfurt dabei sein. Die Konferenz bietet einen vielfältigen Einblick in die IT-Welt, von Software-Architektur über Agile-Praktikten bis zum zu großen Sprachmodellen. Wir trugen mit zwei Vorträgen zu Unit-Testing und Personalisierung mit LLMs spannende Themen für Data Scientists bei.

rwthGPT – Eine datenschutzkonforme Plattform für OpenAI-Modelle

Zusammen mit der RWTH Aachen University haben wir rwthGPT entwickelt: Eine datenschutzkonforme Plattform zur Nutzung von OpenAI-Modellen für Studierende und Mitarbeitende. Ergänzt wird rwthGPT durch ein dediziertes User-Management mit Kostenzuordnung, das Speichern von Chat-Verläufen und Talk to your Data. Wir werfen einen detaillierten Blick auf die Datenschutz-relevanten Aspekte.

data2day 2023

Auf der data2day 2023 im Oktober in Karlsruhe wurden die neuesten Datenanalyse-Technologien anhand von Datenprojekten diskutiert. Neben Data Mesh und großen Sprachmodellen (LLMs) stellten Martin Danner und Jan Höllmer scieneers-Projekte mit Temporal Fusion Transformer (TFT) zu Prognose und Anomalie-Erkennung bei Iqony vor.

Individualisierung von Konferenz-Programmen durch LLMs

Vor einem Jahr wurde ChatGPT vorgestellt, seitdem sind Sprachmodelle das mit Abstand am meisten diskutierte Thema der IT-Geschäftswelt. Große Sprachmodelle wie ChatGPT haben zahllose Anwendungsfälle, eines davon ist die Verwendung um Texte personalisiert, also an den Präferenzen der Nutzer orientiert, wiederzugeben. Ein Beispiel hierfür ist die Erstellung von individuellen Programmplänen. Wir haben eine Anwendung implementiert, die basierend auf einem User-Input und einer Vektordatenbank individuelle Programmpläne für die IT-Tage 2023 in Frankfurt am Main erstellt. Hier geben wir einen kurzen Einblick in die Implementierung.

Data Platform auf Azure – aber bitte sicher!

Viele Unternehmen nutzen inzwischen die Azure Data Services für Data Management und Analytics Aufgaben oder planen den Umstieg auf Microsofts Cloud Platform. Viele Gründe wie Betriebskosten und Skalierbarkeit sprechen dafür, aber wie ist es um die Sicherheit bestellt? In dem Vortrag schauen wir uns an, welche Mechanismen auf Azure zum sicheren Datenaustausch genutzt werden können. wie der Datenzugriff von Dienste- bis bis auf Datenebene für Endbenutzer konfiguriert werden kann und welche Möglichkeiten es gibt, die Services netzwerktechnisch sicher zu verbinden und gleichzeitig vor unerwünschten Besuchern abzuschotten.

Optimize an AI Powered Recommendation Engine

scieneers, Intel Corporation, and Von Rundstedt joined forces to optimize an AI powered recommendation engine solution that leverages the Intel® AI Analytics Toolkit and 4th Generation Intel® Xeon® Scalable Processors. In this brief experience report we demonstrate how we managed to achieve up to 9.3X speedup when running on 4th Generation Intel® Xeon® Scalable Processors compared to the baseline configuration. This means that the solution can process more data faster, generate more accurate recommendations, and serve more users with lower latency and cost.

LLMs und Cloud-Technologien zur Vernetzung von Onlineshops der Otto-Gruppe

Large Language Models (LLMs) sind wegen ihrer vielfältigen Anwendungen in aller Munde. Auch im E-Commerce Bereich ist diese Technologie sehr nützlich. Zusammen mit der data.works GmbH haben wir sogenannte Embedding-Modelle aus dem LLM-Bereich mit der Vertex AI Matching Engine in der Google Cloud für mehrere Onlineshops der Otto-Gruppe eingesetzt, um kundenspezifische Produktempfehlungen aus einem Shop auf viele andere Shops übertragen zu können. Und das, obwohl sich die Sortimente und Kataloge dieser Shops stark unterscheiden.

Wärmebedarf prognostizieren mit Temporal Fusion Transformern

Zusammen mit Iqony haben wir den Einsatz von Temporal Fusion Transformern zur Bedarfsprognose in der Fernwärme getestet. Durch Data Fusion können die Vorhersagen von mehreren Standorten in einem Modell vereint und vor allem die Vorhersagegenauigkeit von Standorten mit wenig Daten gesteigert werden. Die Quantisierung von Vorhersageunsicherheiten und die Interpretierbarkeit des Modells schaffen Vertrauen und unterstützen die Entscheidungsfindung.

Moodle Chatbot – KI als persönlicher Uni-Dozent

Zusammen mit der RWTH Aachen haben wir einen Chatbot entwickelt, der einen nahtlosen Zugang zu Vorlesungsinhalten für Studierende und Mitarbeitende direkt in der Lernplattform Moodle ermöglicht. Somit können themenspezifische Fragen mit Inhalten aus einer Vorlesung beantwortet werden. Eine zusätzliche Quellenangabe erlaubt außerdem das schnelle Finden der relevanten Vorlesungsinhalte in den Unterlagen.

KI-basierte Textanalyse für die Energiewirtschaft

Künstliche Intelligenz (KI) erfährt durch ChatGPT derzeit enorme Aufmerksamkeit. Abseits vom Hype haben die aktuellsten Entwicklungen die Verarbeitung von Sprache und Texten auf ein neues Niveau gehoben. In diesem Artikel wollen wir Ihnen zeigen, was ChatGPT & Co. im Kontext der Energiewirtschaft wirklich leisten können, was das Neue daran ist und wie man diese Tools in der Praxis einsetzen kann.